Probabilités

Loi Binomiale

D’une épreuve de Bernoulli à la loi binomiale :

Loi normale

La célèbre gaussienne (ou courbe en cloche) :

Densité de probabilités

Nouvelle énigme permettant de parler des densités de probabilité :

Quelle est la distance moyenne entre deux points pris au hasard sur un segment ?

On peut vérifier la solution statistiquement avec un petit programme simplissime :

Probabilités conditionnelles et Bayes

Les probabilités conditionnelles au tribunal, chez le médecin et dans un vieux jeu télévisé américain :

Chaînes de Markov

Le jeu de Penney a d’étonnantes propriétés. Les chaînes de Markov aident à le démystifier :

Curiosités et énigmes

Spaghetti et inégalité triangulaire

Une petite énigme à base d’inégalité triangulaire :

Quelle est la probabilité de pouvoir faire un triangle avec les 3 bouts obtenus en cassant aléatoirement un spaghetti en deux endroits ?

Anniversaires simultanés

Quelle est la probabilité que deux élèves d’une classe est un anniversaire le même jour ?

Lorsqu’on n’a jamais fait le calcul ou entendu parler du résultat, notre intuition nous amène généralement à soupçonner une probabilité bien plus petite qu’elle ne l’est.

C’est d’ailleurs assez fréquent que notre intuition soit aux fraises lorsqu’il s’agit d’estimer une probabilité ou expliquer des statistiques (voir le paradoxe de Simpson plus bas).

Paradoxe des deux enfants

Le paradoxe des deux enfants repose grandement sur la formulation et provoque encore parfois des débats passionnés.

Les probabilités sont des calculs a priori, visant à prédire les issues d’évènements n’ayant pas encore eu lieu, alors que les statistiques sont des calculs a posteriori qui analysent les issues d’évènements déjà réalisés.

Statistiques

Les différentes moyennes

Monte Carlo

Dans la duxième partie de la vidéo, on cherche à répondre à la grande question suivante : comment s’assurer d’avoir suffisamment d’échantillons pour obtenir des statistiques fiables ? Ou plus prosaïquement : à partir de combien est-ce suffisant ? On utilise d’abord les propriétés de la loi normale puis on construit un estimateur à partir de l’inégalité de Bienaymé-Tchebychev.

Paradoxe de Simpson

Ce paradoxe a fait des dégâts lors de la campagne de vaccination pour le Covid. Les chiffres de la vidéo sont proches des chiffres communiqués par l’état d’Israël qui était un des premiers pays à pouvoir vacciner.

L’article qui a servi en partie pour la vidéo.

Test d’hypothèse

Les statistiques au service de la prise de décision en science.

Analyse en composante principale

L’analyse en composante principale permet de faire parler les données.

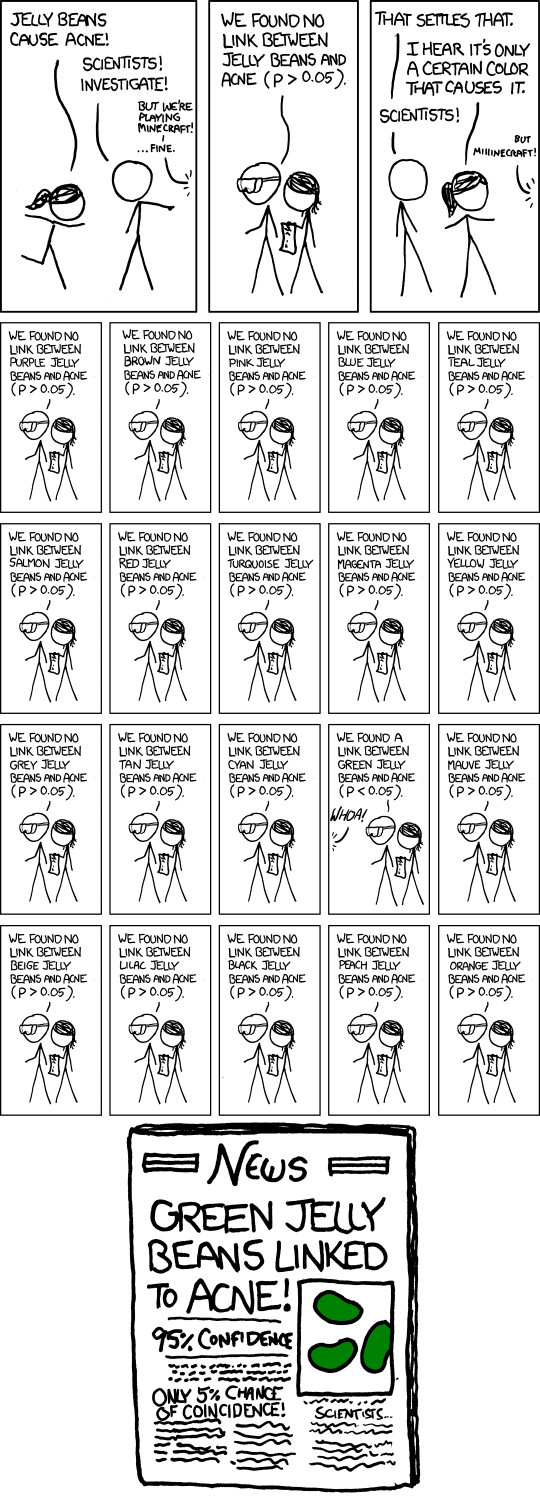

p-hacking

Peut-être que l’exemple le plus célèbre est celui du scientifique de l’alimentation Brian Wansink, une star de l’Université Cornell qui a reçu des millions de dollars de financement du gouvernement fédéral américain sous l’administration Obama. Il a publié beaucoup d’études sur notre comportement alimentaire, notamment une sur la façon dont les hommes mangent plus en compagnie de femmes (probablement pour les impressionner) ; une autre sur comment donner des noms plus “attractifs” aux légumes (appeler les carottes “carottes à vision X-ray,” par exemple) permet que les enfants d’école primaire en mangent deux fois plus.

Puis, en 2016, il a commis l’erreur de publier un billet de blog intitulé “The Grad Student Who Never Said ‘No.’”.

L’étudiante en question était une doctorante turque. Lorsqu’elle est arrivée à Cornell, Wansink “lui a donné un ensemble de données d’une étude autofinancée, sans résultats probants” - une étude qui examinait le comportement alimentaire dans un buffet italien à volonté pendant un mois. Selon ses propres termes, il lui a dit : “Cela nous a coûté beaucoup de temps et d’argent à collecter. Il doit y avoir quelque chose ici que nous pouvons sauver parce que cet ensemble de données est cool (riche et unique).” L’étudiante s’est donc mise au travail et a découpé l’ensemble de données de nombreuses façons différentes. Et, inévitablement, elle a trouvé de nombreuses corrélations p < 0,05 - suffisamment pour qu’elle et Wansink publient cinq articles (y compris l’article “les hommes mangent trop pour impressionner les femmes”).

Cela a éveillé la suspicion de certains scientifiques et journalistes scientifiques, et ils ont commencé à passer au crible les autres recherches de Wansink. De plus, Stephanie Lee, une journaliste scientifique de BuzzFeed, a mis la main sur ses emails, dans lesquels - il s’est avéré - il demanda à sa doctorante de découper les données en “mâles, femelles, mangeurs de déjeuner, mangeurs de dîner, personnes mangeant seules, personnes mangeant en groupe de 2, personnes mangeant en groupe de 2+, personnes commandant de l’alcool, personnes commandant des boissons non alcoolisées, personnes restant près du buffet, personnes s’asseyant loin, etc.” pour “essorer le jeu de données jusqu’à en extraire tous les résultats significatifs possibles” et faire en sorte que cela “devienne viral à grande échelle.”

En conséquence, dix-huit des articles de Wansink ont été rétractés ; sept ont reçu des “expressions of concern” que les revues ajoutent aux études qu’elles ne pensent pas pouvoir être totalement fiables, mais qu’elles ne sont pas prêtes à rétracter complètement ; et quinze ont été corrigés. Wansink, entre-temps, a démissionné de Cornell en 2019, après que l’université a conclu qu’il avait commis une faute scientifique et lui a interdit l’enseignement et la recherche.

C’est un exemple particulièrement frappant, mais d’une certaine manière Wansink a eu la malchance d’être détruit publiquement pour quelque chose qui était presque une pratique standard. Le p-hacking se produit tout le temps, de manière beaucoup moins dramatique - et beaucoup de scientifiques n’ont absolument aucune idée qu’ils font quelque chose de mal. Daryl Bem, dans un chapitre d’un livre de 1987 écrit comme un guide pour aider les étudiants à publier leurs recherches, a écrit qu’il “y a deux articles que vous pouvez écrire : l’article que vous aviez prévu d’écrire lorsque vous avez conçu votre étude ; l’article qui a le plus de sens maintenant que vous avez vu les résultats. La bonne réponse est le second.” Il a appelé les chercheurs à “analyser les sexes séparément, créer de nouveaux index composites… réorganiser les données pour les mettre en relief de manière plus audacieuse… Les données peuvent être suffisamment solides pour justifier de recentrer votre article autour des nouvelles découvertes et de subordonner ou même d’ignorer vos hypothèses originales.”

Comme on l’a vu sur les espaces de données à grande dimension , plus on a d’axes (de catégories, d’entrées,…), plus on a de chance d’obtenir un résultat hors norme sur au moins l’un d’eux.

Ce chouette site met le phénomène à profit pour débusquer des corrélations amusantes (avec pour chacune des p-values inférieures à 1%…).

Écart-type expérimental (estimateur de l’écart-type non biaisé)

L’écart-type pour une variable quantitative dont les relevés $(x_1,\ldots,x_N)$ sont pris sur la population complète (avec pour moyenne $\mu$) est donné par la racine carrée de la variance :

$$\sigma = \sqrt{V}=\sqrt{\frac{1}{N}\sum_{i=1}^N (x_i-\mu)^2}$$

C’est donc la racine-carrée des carrés des écarts à la moyenne divisé par $N$. On obtient bien ainsi une moyenne des écarts à la moyenne en empèchant qu’un écart en-dessous ne compense une écart au-dessus.

Mais si les relevés ne concernent qu’un échantillon $n<N$ de la population et non la population complète (ce qui est le cas pour une série de mesures expérimentales), on passe des probas aux stats et on a alors besoin d’un estimateur de l’écart-type ($\sigma\rightarrow S$).

L’estimateur de l’écart-type non biaisé (aussi appelé écart-type expérimental) est alors donné par :

L’estimateur non biaisé de l’écart-type est parfois appelé écart-type expérimental et noté $\sigma_{exp}$. C’est particulièrement le cas dans l’enseignement de la physique au lycée.

Pourquoi “non biaisé” ? Et pourquoi passer de “$n$” à “$n-1$" ?

Notre problème est qu’on ne connaît plus la valeur vraie de la moyenne $\mu$ mais seulement son estimation $m=\frac{1}{n}\sum_{i=1}^n x_i$.

Et en substituant $m$ à $\mu$ dans la variance, on biaise son espérance…

En effet :

Par conséquent, on multiplie par $\frac{n}{n-1}$ pour se débarrasser du biais…